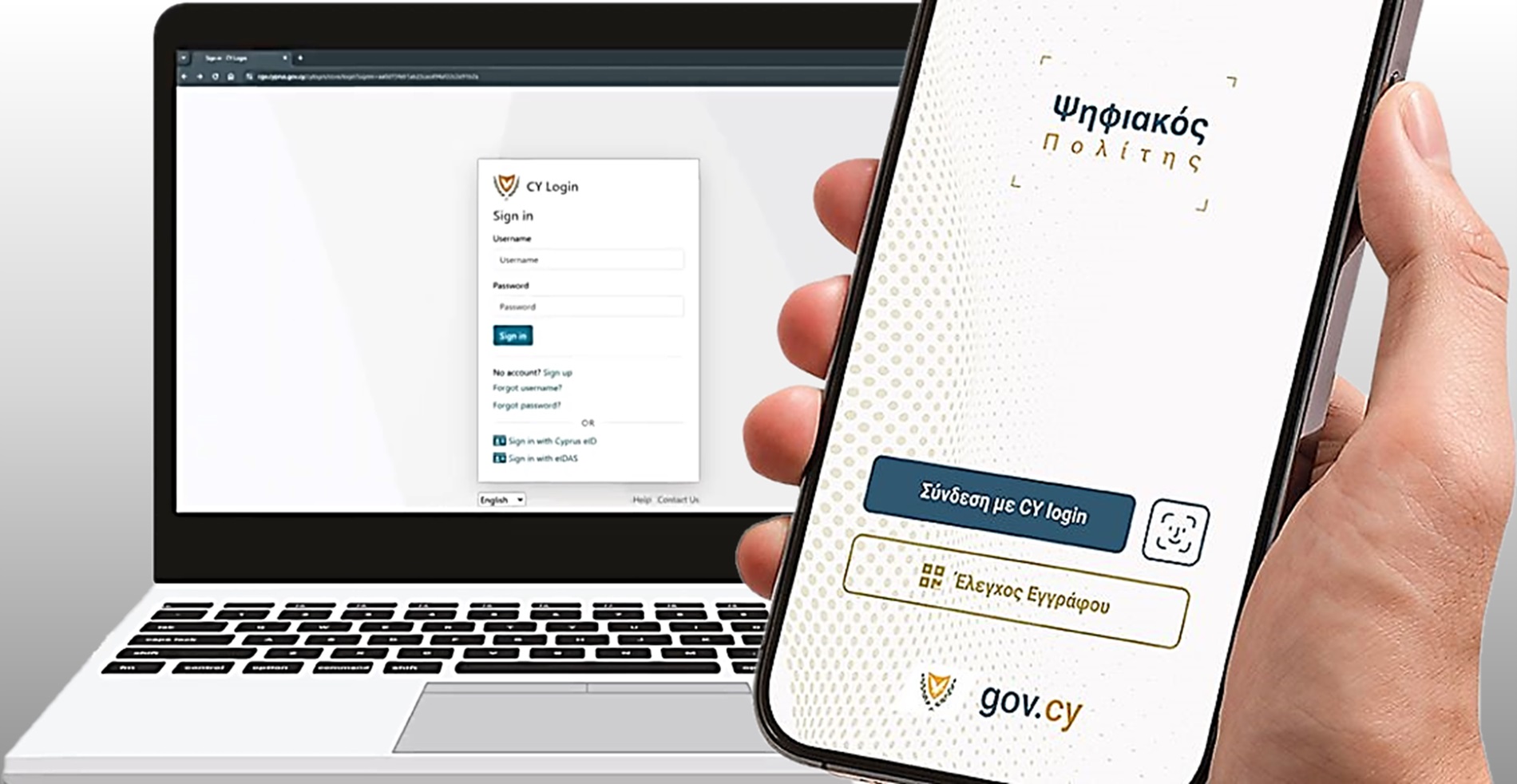

«Η τεχνητή νοημοσύνη είναι απλώς λογισμικό βασισμένο σε στατιστικές πιθανότητες», αυτό τόνισε ο Jonathan Soma, στο πλαίσιο του Διεθνούς Συνεδρίου του IQ Media που πραγματοποιήθηκε στις 14 και 15 Απριλίου στην Αθήνα και διοργανώθηκε από τον Όμιλο Nice-Matin και το Εθνικό και Καποδιστριακό Πανεπιστήμιο Αθηνών.

Κάθε φορά που ζητάμε από ένα εργαλείο AI να δημιουργήσει κείμενο, αυτό αναλύει δεδομένα από το διαδίκτυο και προβλέπει ποια λέξη είναι πιο πιθανό να ακολουθήσει. Η AI δεν είναι σταθερή: η ίδια ερώτηση μπορεί να δώσει διαφορετικές απαντήσεις, ανάλογα με μια ρύθμιση που ονομάζεται «temperature». Όσο υψηλότερη είναι η τιμή της, τόσο λιγότερο προβλέψιμη θα είναι η απάντηση.

Τα κύρια χαρακτηριστικά της AI είναι οι παραισθήσεις (hallucinations), οι μεροληψίες (bias) και η χαμηλή ποιότητα ορισμένων αποτελεσμάτων. Ο κ. Soma εξήγησε ότι τα λάθη της AI κατατάσσονται σε τρεις βασικές κατηγορίες:

Η πρώτη αφορά χαμηλής σημασίας λάθη, όπου η ποιότητα του αποτελέσματος μπορεί να αγνοηθεί. Για παράδειγμα, η AI μπορεί να μπερδέψει ένα όνομα με το φύλο του ή να δημιουργήσει κείμενα για μη φυσικούς ομιλητές της αγγλικής γλώσσας που περιέχουν λάθη, τα οποία συχνά δεν ελέγχονται. Ορισμένα εργαλεία δείχνουν ότι περίπου το 30% του περιεχομένου μπορεί να περιέχει λανθασμένες πληροφορίες, οι οποίες όμως συχνά αγνοούνται από τον χρήστη.

Η δεύτερη κατηγορία περιλαμβάνει περιπτώσεις με περιορισμένο περιθώριο σφάλματος, όπου η AI δεν απειλεί τη δημοσιογραφία. Ο δημοσιογραφικός έλεγχος των πληροφοριών είναι προσιτός και η ανθρώπινη παρέμβαση μπορεί να εντοπίσει και να διορθώσει λάθη. Παράλληλα, τα κείμενα που παράγει η AI είναι συχνά μονοτονικά, προβλέψιμα και βαρετά, καθώς βασίζονται σε στατιστικές προβλέψεις για την επόμενη λέξη.

Η τρίτη κατηγορία περιλαμβάνει περιπτώσεις όπου αναμένονται υψηλά ποσοστά σφαλμάτων. Τα μεγάλα γλωσσικά μοντέλα (LLMs) βασίζονται σε στατιστική πιθανότητα, η οποία δεν συνδέεται πάντα με την πραγματικότητα. Η AI μπορεί να δημιουργεί περιεχόμενο που δεν αντικατοπτρίζει την αλήθεια, να «παρανοεί» χιούμορ ή να παράγει αστεία λάθος δεδομένα — όπως να δώσει λανθασμένο μενού σε ένα εστιατόριο. Στη δημοσιογραφία όμως, ένα μόνο λάθος μπορεί να αλλάξει εντελώς το νόημα ενός κειμένου, καθιστώντας την ανθρώπινη επαλήθευση απαραίτητη.

Το βασικό μήνυμα του workshop ήταν σαφές: η τεχνητή νοημοσύνη είναι εργαλείο με δυνατότητες αλλά και περιορισμούς, και κάθε χρήστης, ιδίως στον χώρο της δημοσιογραφίας, πρέπει να γνωρίζει τα όρια της και να ελέγχει προσεκτικά τα αποτελέσματά της.

*Το έργο «IQ Media» υλοποιείται με τη χρηματοδότηση της Ευρωπαϊκής Ενωσης. Οι απόψεις και οι γνώμες που διατυπώνονται εκφράζουν αποκλειστικά τις απόψεις των συντακτών και δεν αντιπροσωπεύουν κατ’ ανάγκη τις απόψεις της Ευρωπαϊκής Ενωσης ή του Ευρωπαϊκού Εκτελεστικού Οργανισμού Εκπαίδευσης και Πολιτισμού (EACEA). Η Ευρωπαϊκή Ενωση και ο EACEA δεν μπορούν να θεωρηθούν υπεύθυνοι για τις εκφραζόμενες απόψεις. Η παραπάνω δημοσίευση συγχρηματοδοτείται από την Ε.Ε. στο πλαίσιο του προγράμματος “IQ Media: a collaborative framework towards business transformation, Innovation, Quality journalism, and advanced digital skills in the Media environment covering Greece, Cyprus, France, and Portugal.” -“IQMedia” με ΑΡΙΘΜΟ ΣΥΜΒΑΣΗΣ 101112285